Internet

Les robots des réseaux sociaux peuvent sembler humains, mais leurs personnalités similaires les trahissent

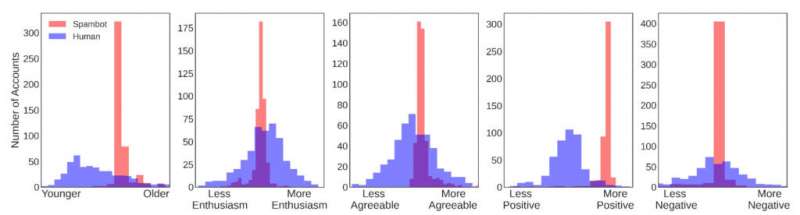

Répartition des comptes humains (bleu) et bot (rouge) selon l’âge, la personnalité et le sentiment. Pour chaque trait, les comptes humains ont un large éventail de valeurs, tandis que les comptes de robots sont tous regroupés dans une petite plage. Pour l’enthousiasme, l’amabilité et la négativité, les robots sont regroupés autour du centre de la distribution humaine, montrant que ces comptes présentent des traits très moyens. Crédit : Université de Pennsylvanie

Les robots sociaux, ou comptes de médias sociaux automatisés qui se font passer pour de véritables personnes, ont infiltré toutes sortes de discussions, y compris des conversations sur des sujets conséquents, tels que la pandémie de COVID-19. Ces robots ne sont pas comme les appels automatisés ou les e-mails de spam ; des études récentes ont montré que les utilisateurs de médias sociaux les trouvent pour la plupart indiscernables des vrais humains.

Maintenant, une nouvelle étude menée par des chercheurs de l’Université de Pennsylvanie et de l’Université Stony Brook, publiée dans Findings of the Association for Computational Linguistics, examine de plus près comment ces robots se déguisent. Grâce à des techniques d’apprentissage automatique et de traitement du langage naturel de pointe, les chercheurs ont estimé à quel point les robots imitent 17 attributs humains, notamment l’âge, le sexe et une gamme d’émotions.

L’étude met en lumière la façon dont les bots se comportent sur les plateformes de médias sociaux et interagissent avec des comptes authentiques, ainsi que les capacités actuelles des technologies de génération de bots.

Il suggère également une nouvelle stratégie pour détecter les bots : alors que le langage utilisé par un bot reflétait de manière convaincante des traits de personnalité humains, leur similitude les uns avec les autres trahissait leur nature artificielle.

« Cette recherche nous donne un aperçu de la façon dont les robots peuvent interagir avec ces plates-formes sans être détectés », a déclaré l’auteur principal Salvatore Giorgi, étudiant diplômé du Département d’informatique et des sciences de l’information (CIS) de la Penn’s School of Engineering and Applied Science. « Si un utilisateur de Twitter pense qu’un compte est humain, il est plus susceptible de s’engager avec ce compte. Selon l’intention du bot, le résultat final de cette interaction peut être anodin, mais cela peut également conduire à une désinformation potentiellement dangereuse. . »

Avec Giorgi, la recherche a été menée par Lyle Ungar, professeur au CIS, et l’auteur principal H. Andrew Schwartz, professeur agrégé au département d’informatique de l’université Stony Brook.

Certains des travaux antérieurs des chercheurs ont montré comment le langage des publications sur les réseaux sociaux peut être utilisé pour prédire avec précision un certain nombre d’attributs de l’auteur, notamment son âge, son sexe et son score à un test des « Big Five » traits de personnalité. : ouverture à l’expérience, conscience, extraversion, amabilité et névrosisme.

La nouvelle étude a examiné plus de 3 millions de tweets créés par trois mille comptes de bots et un nombre égal de comptes authentiques. En se basant uniquement sur la langue de ces tweets, les chercheurs ont estimé 17 caractéristiques pour chaque compte : âge, sexe, traits de personnalité des Big Five, huit émotions (telles que la joie, la colère et la peur) et sentiment positif/négatif.

Leurs résultats ont montré que, individuellement, les bots ont l’air humains, ayant des valeurs raisonnables pour leurs estimations démographiques, leurs émotions et leurs traits de personnalité. Cependant, dans l’ensemble, les robots sociaux ressemblent à des clones les uns des autres, en termes de valeurs estimées pour les 17 attributs.

De manière écrasante, les robots de langage utilisés semblaient être caractéristiques d’une personne à la fin de la vingtaine et extrêmement positifs.

L’analyse des chercheurs a révélé que l’uniformité des scores des robots sociaux sur les 17 traits humains était si forte qu’ils ont décidé de tester dans quelle mesure ces traits fonctionneraient comme les seules entrées d’un détecteur de robots.

« Imaginez que vous essayez de trouver des espions dans une foule, tous avec de très bons déguisements mais aussi très similaires », dit Schwartz. « En regardant chacun individuellement, ils ont l’air authentiques et se fondent extrêmement bien. Cependant, lorsque vous effectuez un zoom arrière et regardez toute la foule, ils sont évidents car le déguisement est tellement courant. La façon dont nous interagissons avec les médias sociaux, nous sommes pas de zoom arrière, nous ne voyons que quelques messages à la fois. Cette approche donne aux chercheurs et aux analystes de la sécurité une vue d’ensemble pour mieux voir le déguisement commun des robots sociaux. «

En règle générale, les détecteurs de bots s’appuient sur plus de fonctionnalités ou sur une combinaison complexe d’informations provenant du réseau social du bot et des images qu’ils publient. Schwartz et Giorgi ont découvert qu’en regroupant automatiquement les comptes en deux groupes basés uniquement sur ces 17 traits et sans étiquettes de bot, l’un des deux groupes a fini par être presque entièrement des bots. En fait, ils ont pu utiliser cette technique pour fabriquer un détecteur de bots non supervisé, et il correspondait approximativement à la précision de l’état de l’art (taux de vrais positifs : 0,99, sensibilité/rappel : 0,95).

« Les résultats n’étaient pas du tout ce à quoi nous nous attendions », a déclaré Giorgi. « L’hypothèse initiale était que les comptes de bots sociaux auraient clairement l’air inhumains. Par exemple, nous pensions que notre classificateur pourrait estimer l’âge d’un bot à 130 ou moins 50 ans, ce qui signifie qu’un utilisateur réel serait en mesure de dire que quelque chose n’allait pas. Mais sur les 17 traits, nous avons principalement trouvé que les bots se situaient dans une plage « humaine », même s’il y avait une variation extrêmement limitée au sein de la population de bots. »

En revanche, lorsque l’on examine les estimations des traits humains des robots non sociaux, des comptes automatisés qui ne tentent pas de cacher leur nature artificielle, les distributions des traits correspondent à celles de l’hypothèse d’origine : des valeurs estimées qui se situent en dehors des plages humaines normales et apparemment aléatoires. distributions au niveau de la population.

« Il y a beaucoup de variations dans le type de comptes que l’on peut rencontrer sur Twitter, avec un paysage presque de la science-fiction : humains, clones ressemblant à des humains prétendant être des humains et robots », explique Giorgi.

Les bots n’étaient pas très actifs sur Twitter lors des élections municipales finlandaises

Salvatore Giorgi et al, Caractériser les spambots sociaux par leurs traits humains, Résultats de l’Association for Computational Linguistics : ACL-IJCNLP 2021 (2021). DOI : 10.18653/v1/2021.findings-acl.457

Fourni par l’Université de Pennsylvanie

Citation: Les robots des réseaux sociaux peuvent sembler humains, mais leurs personnalités similaires les trahissent (2021, 24 novembre) récupéré le 24 novembre 2021 sur https://techxplore.com/news/2021-11-social-media-bots-human-similar. html

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans l’autorisation écrite. Le contenu est fourni seulement pour information.

Sommaire