Pomme annoncé une nouvelle politique de sécurité des enfants pour analyser automatiquement les photos des utilisateurs à la recherche de matériel d’agression sexuelle d’enfants (CSAM) le mois dernier, suscitant un tollé des défenseurs de la vie privée et des consommateurs au sujet des violations des droits à la vie privée et de l’exploitation potentielle par le gouvernement. Maintenant, Apple retarde le déploiement de la technologie pour solliciter des commentaires «au cours des prochains mois» avant sa sortie complète.

Apple prévoyait auparavant d’inclure sa technologie de numérisation CSAM et une politique facultative d’accompagnement pour filtrer le contenu sexuel dans iMessages pour les jeunes dans iOS 15 et iPadOS 15, qui devraient être lancés aux côtés de l’iPhone 13 (dont la rumeur veut qu’elle soit dévoilée le 14 septembre). Il aurait été mis en ligne aux États-Unis, sans aucun plan déclaré pour un déploiement mondial. iVoici la déclaration complète d’Apple sur le retard, par TechCrunch:

« Le mois dernier, nous avons annoncé des plans pour des fonctionnalités destinées à aider à protéger les enfants contre les prédateurs qui utilisent des outils de communication pour les recruter et les exploiter, et à limiter la propagation du matériel d’abus sexuel d’enfants. Sur la base des commentaires des clients, des groupes de défense des droits, des chercheurs et d’autres, nous avons décidé de prendre plus de temps au cours des prochains mois pour recueillir des commentaires et apporter des améliorations avant de publier ces fonctionnalités de sécurité des enfants d’une importance cruciale.

Peu de temps après l’introduction des nouvelles politiques début août via un article de blog, Apple a suivi avec un multipage FAQ donnant des explications détaillées sur le fonctionnement de l’analyse CSAM et du filtrage iMessage pour les jeunes.

Apple prévoyait d’utiliser sa soi-disant technologie NeuralHash pour numériser automatiquement les photos pour voir si elles correspondaient aux hachages de matériel CSAM connu. La technologie n’a numérisé que les images au fur et à mesure qu’elles étaient téléchargées sur iCloud (qui est crypté).

Mais le potentiel pour les gouvernements d’exploiter la politique de numérisation automatique de photos pour leurs propres usages avait alarmé les défenseurs de la vie privée et les groupes industriels – le Fondation de la frontière électronique (EFF) a critiqué l’entreprise pour avoir intégré tout type de « porte dérobée » dans les données des utilisateurs, tandis que le Centre pour la démocratie et la technologie (CDT) a rassemblé une coalition dénonçant comment une telle numérisation de photos pourrait être abusée par des gouvernements à la recherche de matériel répréhensible.

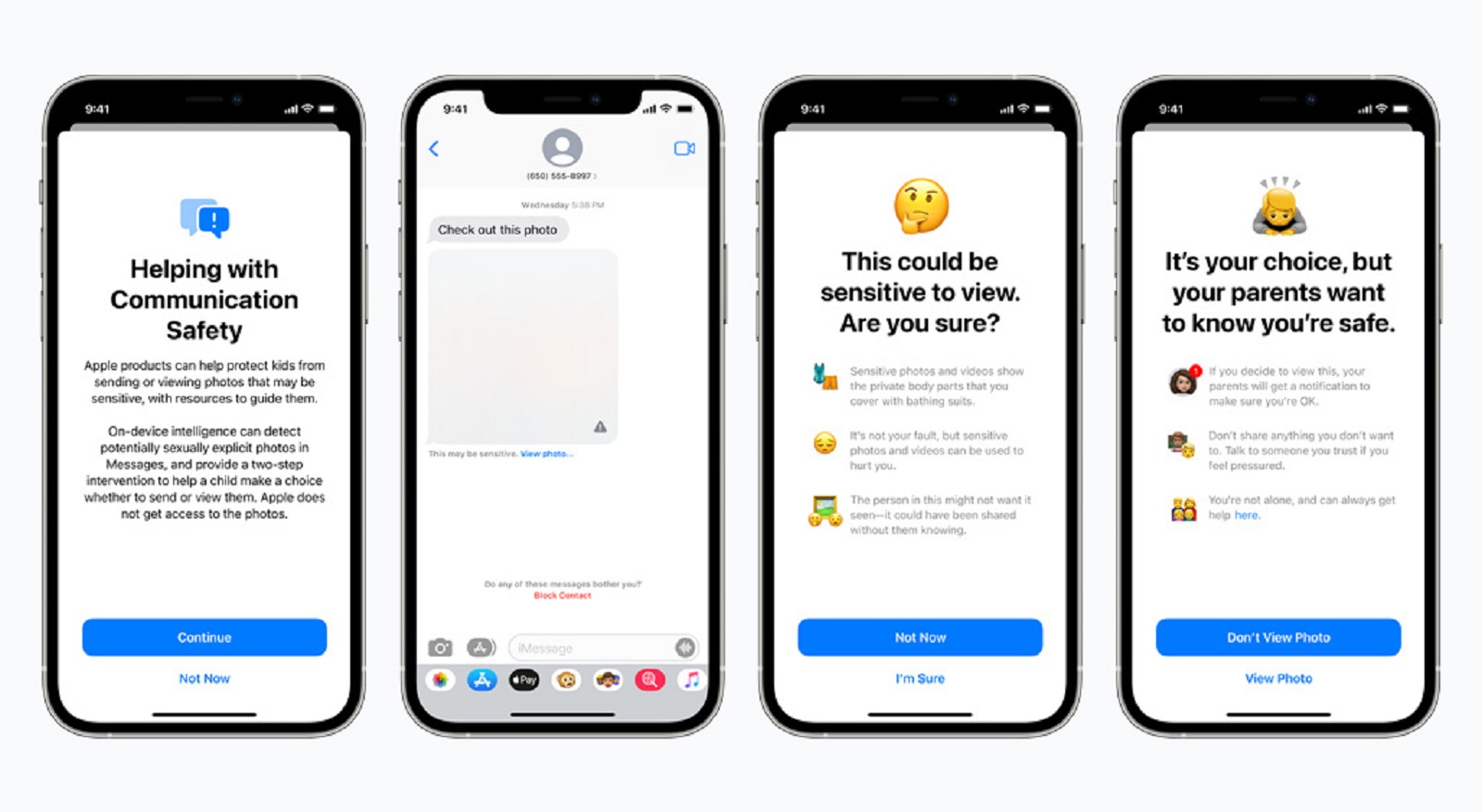

Le CDT a également expliqué comment une autre politique qu’Apple prévoyait de déployer parallèlement à la numérisation de photos CSAM – une fonctionnalité facultative d’iMessage qui brouille les images à contenu sexuel envoyées aux utilisateurs de moins de 13 ans et informe les parents liés au même compte familial – pourrait « menacer le la sécurité et le bien-être de certains jeunes, et les jeunes LGBTQ+ dont les parents sont antipathiques sont particulièrement à risque.

Enfin, Apple allait également permettre à Siri et à la recherche de fournir des ressources plus utiles aux utilisateurs demandant de signaler le CSAM, ainsi que d’intervenir avec des avertissements et des ressources d’assistance lorsque les utilisateurs recherchent du matériel lié au CSAM. On ne sait pas si cela sera également retardé.

Sommaire

Analyse : un pas en arrière pour Apple, un pas en avant pour la vie privée

Les groupes et les individus qui s’opposent à la nouvelle politique d’Apple ont critiqué les méthodes du géant de la technologie, pas son intention. En plus de s’opposer à la manière dont cela violerait la vie privée des utilisateurs et ouvrirait une porte dérobée à l’exploitation gouvernementale, ils ont critiqué le potentiel de faux positifs avec l’analyse CSAM elle-même.

Par exemple, Apple a souligné que ses employés ne verraient aucune image téléchargée sur iCloud qui aurait été automatiquement numérisée à moins qu’elle ne dépasse un seuil de hachage CSAM – en d’autres termes, que le hachage d’une image (une empreinte numérique de lettres et de chiffres) ait trouvé une correspondance dans une base de données de CSAM connus.

Alors que la correspondance de hachage est une méthode utilisée, par exemple, par Microsoft pour ses PhotoADN technologie, société de sécurité de site Web CloudFlare, et contre le trafic sexuel d’enfants à but non lucratif Épine, des chercheurs en sécurité auraient répliqué le code NeuralHash d’Apple et auraient pu générer une « collision de hachage » où deux images visiblement différentes pouvaient produire le même hachage, selon TechCrunch.

Bien que nous ne sachions pas la véritable efficacité des protocoles de sécurité des enfants d’Apple avant leurs débuts, il semble qu’Apple prenne les critiques et les préoccupations suffisamment au sérieux pour prendre quelques mois pour affiner son approche, ce qui signifie que nous ne le verrons peut-être pas se déployer avant la fin. de 2021 ou 2022.