Gadgets

Lorsque les assistants vocaux écoutent alors qu'ils ne devraient pas

Cet assistant vocal ne réagit pas seulement au mot déclencheur «Amazon», mais est également activé par la phrase «et la zone». Crédits: RUB, Marquard

Des chercheurs de la Ruhr-Universität Bochum (RUB) et du Bochum Max Planck Institute (MPI) pour la cybersécurité et la confidentialité ont étudié les mots qui activent par inadvertance les assistants vocaux. Ils ont compilé une liste de termes anglais, allemands et chinois qui ont été mal interprétés à plusieurs reprises par des haut-parleurs intelligents comme des invites. Chaque fois que les systèmes se réveillent, ils enregistrent une courte séquence de ce qui est dit et transmettent les données au fabricant. Les extraits audio sont ensuite transcrits et vérifiés par les employés de la société respective. Ainsi, des fragments de conversations très privées peuvent se retrouver dans les systèmes des entreprises.

Süddeutsche Zeitung et NDR ont rendu compte des résultats de l'analyse le 30 juin 2020. Des exemples fournis par l'analyse des chercheurs peuvent être trouvés sur le site inacceptable-privacy.github.io.

Pour le projet, Lea Schönherr du groupe de recherche RUB Cognitive Signal Processing, dirigée par le professeur Dorothea Kolossa au RUB Horst Görtz Institute for IT Security (HGI), a collaboré avec le Dr Maximilian Golla, auparavant chez HGI, maintenant chez MPI for Security et Confidentialité, ainsi que Jan Wiele et Thorsten Eisenhofer de la chaire HGI pour la sécurité des systèmes dirigée par le professeur Thorsten Holz.

Test de tous les principaux fabricants

Les experts informatiques ont testé les assistants vocaux d'Amazon, Apple, Google, Microsoft et Deutsche Telekom, ainsi que trois modèles chinois de Xiaomi, Baidu et Tencent. Ils leur ont joué des heures de matériel audio en anglais, allemand et chinois, y compris plusieurs saisons de la série "Game of Thrones", "Modern Family" et "House of Cards", ainsi que des émissions de nouvelles. De plus, des ensembles de données audio professionnels utilisés pour former des haut-parleurs intelligents ont également été inclus.

Tous les assistants vocaux ont été équipés d'un capteur de lumière qui s'est enregistré lorsque l'indicateur d'activité du haut-parleur intelligent s'est allumé, permettant ainsi de passer visiblement l'appareil en mode actif indiquant qu'un déclenchement s'est produit. La configuration s'est également enregistrée lorsqu'un assistant vocal a envoyé des données à l'extérieur. Chaque fois que l'un des appareils passait en mode actif, les chercheurs ont enregistré la séquence audio qui l'avait provoquée. Ils ont ensuite évalué manuellement les termes qui avaient déclenché l'assistant.

Les chercheurs ont utilisé leur configuration pour analyser onze haut-parleurs intelligents différents, y compris des appareils d'Amazon, Apple, Google, Microsoft et Deutsche Telekom. Crédits: RUB, Marquard

Faux déclencheurs identifiés et générés

Sur la base de ces données, l'équipe a créé une liste de plus de 1 000 séquences qui déclenchent incorrectement des assistants vocaux. Selon la prononciation, Alexa réagit aux mots «inacceptable» et «élection», tandis que Google réagit à «OK, cool». Siri peut être trompé par «une ville», Cortana par «Montana», Computer par «Peter», «Amazon par» et la zone »et Echo par« tabac ».

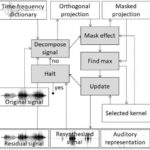

Afin de comprendre ce qui fait de ces termes de faux déclencheurs, les chercheurs ont décomposé les mots en leurs plus petites unités sonores possibles et identifié les unités qui étaient souvent confondues par les assistants vocaux. Sur la base de ces résultats, ils ont généré de nouveaux mots déclencheurs et ont montré que ces termes activaient également les assistants vocaux.

"Les appareils sont intentionnellement programmés d'une manière un peu indulgente, car ils sont censés être capables de comprendre leurs humains. Par conséquent, ils sont plus susceptibles de démarrer une fois trop souvent plutôt que pas du tout", conclut Dorothea Kolossa.

À l'aide de capteurs de lumière, ils se sont enregistrés lorsque les voyants lumineux des haut-parleurs se sont allumés. Crédits: Maximilian Golla

Les extraits audio sont analysés dans le cloud

Les chercheurs ont analysé plus en détail comment les fabricants évaluent les faux déclencheurs. Un processus en deux étapes est le plus courant. Tout d'abord, l'appareil analyse localement si le discours qu'il perçoit contient un mot déclencheur. Si l'appareil soupçonne qu'il a entendu le mot déclencheur, il commence à télécharger la conversation en cours dans le cloud du fabricant pour une analyse plus approfondie avec plus de puissance de calcul. Si l'analyse du cloud identifie le terme comme un faux déclencheur, l'assistant vocal reste silencieux, seule sa LED témoin s'allume brièvement. Dans ce cas, plusieurs secondes d'enregistrement audio peuvent déjà se retrouver dans la société, où elles sont transcrites par des humains afin d'éviter de tels faux déclencheurs à l'avenir.

"Du point de vue de la confidentialité, cela est bien sûr alarmant, car parfois des conversations très privées peuvent se retrouver avec des étrangers", explique Thorsten Holz. "D'un point de vue technique, cependant, cette approche est tout à fait compréhensible, car les systèmes ne peuvent être améliorés qu'en utilisant de telles données. Les fabricants doivent trouver un équilibre entre la protection des données et l'optimisation technique."

Comment les assistants vocaux suivent les commandes inaudibles

GitHub: Inacceptable, où est ma vie privée? Exploration des déclencheurs accidentels de haut-parleurs intelligents: inacceptable-privacy.github.io/

Citation:

Quand les orthophonistes écoutent alors qu'ils ne devraient pas (2020, 3 juillet)

récupéré le 3 juillet 2020

depuis https://techxplore.com/news/2020-07-speech-shouldnt.html

Ce document est soumis au droit d'auteur. Hormis toute utilisation équitable aux fins d'études ou de recherches privées, aucun

une partie peut être reproduite sans la permission écrite. Le contenu est fourni seulement pour information.

Sommaire