Internet

Les algorithmes de YouTube pourraient radicaliser les gens, mais nous ne savons pas comment ils fonctionnent

Crédit: M. Tempter / Shutterstock

YouTube crée-t-il des extrémistes? Une étude récente a provoqué des arguments parmi les scientifiques en faisant valoir que les algorithmes qui alimentent le site n'aident pas à radicaliser les gens en recommandant des vidéos toujours plus extrêmes, comme cela a été suggéré ces dernières années.

Le document, soumis à la revue en libre accès First Monday mais qui n'a pas encore été officiellement évalué par les pairs, analyse les recommandations vidéo reçues par différents types de chaînes. Il a affirmé que l'algorithme de YouTube privilégie les canaux médiatiques traditionnels au détriment du contenu indépendant, concluant que la radicalisation a plus à voir avec les personnes qui créent du contenu nuisible que l'algorithme du site.

Les spécialistes dans le domaine ont rapidement répondu à l’étude, certains critiquant les méthodes du papier et d'autres soutenant que l'algorithme était l'un des nombreux facteurs importants et que la science des données seule ne nous donnera pas la réponse.

Le problème avec cette discussion est que nous ne pouvons pas vraiment répondre à la question de savoir quel rôle l'algorithme de YouTube joue dans la radicalisation des gens parce que nous ne comprenons pas comment cela fonctionne. Et ceci n'est qu'un symptôme d'un problème beaucoup plus vaste. Ces algorithmes jouent un rôle croissant dans notre vie quotidienne mais manquent de transparence.

Il est difficile de prétendre que YouTube ne joue aucun rôle dans la radicalisation. Cela a d'abord été souligné par le sociologue de la technologie Zeynep Tufekci, qui a illustré comment les vidéos recommandées poussent progressivement les utilisateurs vers un contenu plus extrême. Selon les mots de Tufekci, les vidéos sur le jogging mènent à des vidéos sur la course à pied des ultramarathons, des vidéos sur les vaccins conduisent à des théories du complot et des vidéos sur la politique mènent à "des démentis de l'Holocauste et d'autres contenus inquiétants".

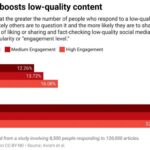

Cela a également été écrit en détail par l'ancien employé de YouTube, Guillaume Chaslot, qui a travaillé sur l'algorithme de recommandation du site. Depuis qu'il a quitté l'entreprise, Chaslot a continué à essayer de rendre ces recommandations plus transparentes. Il dit que les recommandations de YouTube sont biaisées vers les théories du complot et les vidéos factuellement inexactes, qui obligent néanmoins les gens à passer plus de temps sur le site.

En fait, maximiser les temps de visionnage est tout l'intérêt des algorithmes de YouTube, et cela encourage les créateurs de vidéos à se battre pour attirer l'attention de toutes les manières possibles. Le manque de transparence de la société quant à la manière exacte dont cela fonctionne rend pratiquement impossible de lutter contre la radicalisation sur le site. Après tout, sans transparence, il est difficile de savoir ce qui peut être changé pour améliorer la situation.

Mais YouTube n'est pas inhabituel à cet égard. Un manque de transparence sur le fonctionnement des algorithmes est généralement le cas lorsqu'ils sont utilisés dans de grands systèmes, que ce soit par des entreprises privées ou des organismes publics. En plus de décider quelle vidéo vous montrer ensuite, des algorithmes d'apprentissage automatique sont maintenant utilisés pour placer les enfants dans les écoles, décider des peines de prison, déterminer les scores de crédit et les taux d'assurance, ainsi que le sort des immigrants, des candidats et des candidats à l'université. Et généralement, nous ne comprenons pas comment ces systèmes prennent leurs décisions.

Les chercheurs ont trouvé des moyens créatifs de montrer l'impact de ces algorithmes sur la société, que ce soit en examinant la montée de la droite réactionnaire ou la propagation des théories du complot sur YouTube, ou en montrant comment les moteurs de recherche reflètent les préjugés racistes des personnes qui les créent.

Les systèmes d'apprentissage automatique sont généralement gros, complexes et opaques. À juste titre, ils sont souvent décrits comme des boîtes noires, où les informations entrent et les informations ou les actions sortent, mais personne ne peut voir ce qui se passe entre les deux. Cela signifie que, comme nous ne savons pas exactement comment fonctionnent des algorithmes comme le système de recommandation YouTube, essayer de comprendre comment fonctionne le site reviendrait à essayer de comprendre une voiture sans ouvrir le capot.

À son tour, cela signifie qu'essayer d'écrire des lois pour réglementer ce que les algorithmes doivent ou ne doivent pas faire devient un processus aveugle ou un essai et une erreur. C'est ce qui se passe avec YouTube et avec tant d'autres algorithmes d'apprentissage automatique. Nous essayons d'avoir leur mot à dire sur leurs résultats, sans vraiment comprendre comment ils fonctionnent vraiment. Nous devons ouvrir ces technologies brevetées, ou du moins les rendre suffisamment transparentes pour pouvoir les réglementer.

Explications et tests

Une façon de le faire serait que les algorithmes fournissent des explications contrefactuelles avec leurs décisions. Cela signifie élaborer les conditions minimales nécessaires pour que l'algorithme prenne une décision différente, sans décrire sa logique complète. Par exemple, un algorithme prenant des décisions sur les prêts bancaires pourrait produire un résultat indiquant que "si vous aviez plus de 18 ans et que vous n'aviez aucune dette antérieure, votre prêt bancaire serait accepté". Mais cela pourrait être difficile à faire avec YouTube et d'autres sites qui utilisent des algorithmes de recommandation, car en théorie, toute vidéo sur la plate-forme pourrait être recommandée à tout moment.

Un autre outil puissant est le test et l'audit d'algorithmes, qui ont été particulièrement utiles pour diagnostiquer des algorithmes biaisés. Dans un cas récent, une entreprise professionnelle de sélection de curriculum vitae a découvert que son algorithme donnait la priorité à deux facteurs en tant que meilleurs prédicteurs de la performance au travail: si le nom du candidat était Jared, et s'il jouait à la crosse au lycée. C'est ce qui se produit lorsque la machine n'est pas surveillée.

Dans ce cas, l'algorithme de sélection des CV avait remarqué que les hommes blancs avaient plus de chances d'être embauchés et avaient trouvé des caractéristiques de corrélation corrélatives (comme être nommé Jared ou jouer à la crosse) présentes chez les candidats embauchés. Avec YouTube, l'audit d'algorithmes pourrait aider à comprendre quels types de vidéos sont prioritaires pour les recommandations, et peut-être aider à régler le débat sur la contribution des recommandations YouTube à la radicalisation.

Introduire des explications contrefactuelles ou utiliser l'audit d'algorithmes est un processus difficile et coûteux. Mais c'est important, car l'alternative est pire. Si les algorithmes ne sont pas contrôlés et non réglementés, nous pourrions voir un flot progressif de théoriciens du complot et d'extrémistes dans nos médias, et notre attention contrôlée par celui qui peut produire le contenu le plus rentable.

YouTube restreint la recommandation de vidéos de complot

Cet article est republié de The Conversation sous une licence Creative Commons. Lisez l'article original.![]()

Citation:

Les algorithmes de YouTube pourraient radicaliser les gens, mais nous ne savons pas comment ils fonctionnent (2020, 22 janvier)

récupéré le 24 janvier 2020

depuis https://techxplore.com/news/2020-01-youtube-algorithms-radicalize-peoplebut-idea.html

Ce document est soumis au droit d'auteur. Hormis toute utilisation équitable aux fins d'études ou de recherches privées, aucun

une partie peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.

Sommaire