Gadgets

Les utilisateurs doivent désormais choisir entre les options vocales masculines et féminines pour Siri

Crédit : Unsplash/CC0 Domaine public

Depuis le 31 mars 2021, lorsque Apple a publié la mise à jour bêta iOS 14.5 de son système d’exploitation, Siri n’utilise plus par défaut une voix féminine lors de l’utilisation de l’anglais américain. Les utilisateurs doivent désormais choisir entre deux voix masculines et deux voix féminines lors de l’activation de l’assistant vocal. Cette décision pourrait être interprétée comme une réponse à la réaction contre les préjugés sexistes incarnés par Siri

Mais à quel point ce changement est-il vraiment significatif ?

Siri a été critiqué comme incarnant plusieurs facettes des préjugés sexistes dans l’intelligence artificielle. Les sociologues numériques Yolande Strengers et Jenny Kennedy soutiennent que Siri, ainsi que d’autres assistants vocaux tels qu’Amazon Alexa et Google Home, ont été développés afin de « réaliser un « travail d’épouse » – des tâches domestiques qui incombent traditionnellement aux femmes (humaines).

Siri n’était à l’origine exprimé qu’en tant que femme et programmé non seulement pour effectuer des tâches « femmes » telles que vérifier la météo ou régler une alarme matinale, mais aussi pour répondre avec flirt. L’utilisation de phrases sexualisées par Siri a été largement documentée par des centaines de vidéos YouTube avec des titres tels que « Choses que vous ne devriez JAMAIS demander à SIRI » (qui compte plus de 18 millions de vues).

Références de genre datées

Apple a été critiqué pour sa promotion d’une image sexualisée et stéréotypée des femmes qui porte atteinte aux normes de genre. Une enquête 2019 de Le gardien révèle qu’Apple a écrit des directives internes en 2018 demandant aux développeurs de demander à Siri de détourner les mentions du féminisme et d’autres « sujets sensibles ». On ne sait pas quelles étaient les directives pour les retours de dragueur codés en dur.

Le langage utilisé par Siri était (et est toujours) une combinaison d’un modèle de langage déjà stéréotypé, y compris des blagues codées en dur par les développeurs. Une analyse de 2016 des modèles de langage populaires utilisés par les sociétés de logiciels a noté que les associations de mots étaient très stéréotypées. Dans l’étude, des termes tels que philosophe et capitaine étaient de sexe masculin, tandis que l’inverse était vrai pour des termes tels que femme au foyer.

La juriste Céline Castets-Renard et moi-même avons étudié les modèles de langage utilisés par Google Translate et Microsoft Bing qui ont révélé des problèmes similaires. Nous saisissons des phrases neutres en termes de genre en mandarin romanisé dans les plateformes de traduction, forçant les algorithmes de traduction à sélectionner le genre en anglais et en français. Sans exception, l’algorithme de Google a sélectionné les pronoms masculins et féminins selon des critères de genre stéréotypés. L’algorithme de Microsoft, à l’inverse, sélectionne exclusivement des pronoms masculins.

L’utilisation de modèles tels que ceux-ci dans l’algorithme de Siri pourrait expliquer pourquoi, lorsque vous saisissez un titre d’entreprise (directeur général, directeur financier, etc.), un emoji masculin serait proposé. Bien que cela ait depuis été résolu – probablement en raison de critiques – dans le dernier iOS, si Siri est invité à récupérer une photo d’un capitaine ou d’un programmeur, les images servies sont toujours une série d’hommes.

Amical et affectueux

L’idée de l’assistant virtuel parfaitement coquette a inspiré le film 2013 de Spike Jonze Sa, dans lequel le protagoniste masculin tombe amoureux de son assistant virtuel. Mais il est difficile d’imaginer comment des modèles linguistiques biaisés pourraient amener un assistant virtuel à flirter avec les utilisateurs. Cela semble probablement avoir été intentionnel.

En réponse à ces critiques, Apple a progressivement supprimé certains des traits les plus flagrants et apparemment codé en dur certaines des réponses les plus offensantes aux questions des utilisateurs. Cela a été fait sans faire trop de vagues. Cependant, le record de vidéos YouTube montre que Siri devient progressivement moins genrée.

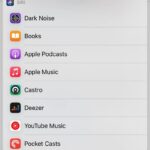

L’une des dernières critiques restantes était que Siri avait une voix féminine, qui restait la voix par défaut même si une voix masculine était également proposée en option depuis son lancement en 2011. Désormais, les utilisateurs doivent décider eux-mêmes s’ils veulent une voix féminine ou masculine.

Cependant, les utilisateurs ne connaissent pas le modèle de langage sur lequel l’assistant virtuel est formé, ni s’il reste encore des héritages de flirty Siri dans le code.

Le biais est plus que profond

Des entreprises comme Apple ont une énorme responsabilité dans l’élaboration des normes sociétales. Un rapport des médias publics nationaux de 2020 a révélé que pendant la pandémie, le nombre d’Américains utilisant des assistants virtuels est passé de 46 à 52%, et cette tendance ne fera que se poursuivre.

De plus, de nombreuses personnes interagissent ouvertement avec des assistants virtuels chez elles, ce qui signifie que les IA biaisées interagissent fréquemment avec les enfants et peuvent fausser leur propre perception des relations humaines entre les sexes.

La suppression de la voix féminine par défaut dans Siri est importante pour le féminisme car elle réduit l’association immédiate de Siri avec les femmes. D’autre part, il y a aussi la possibilité d’utiliser une voix non sexiste, comme celle sortie en 2019 par un groupe dirigé par Copenhagen Pride.

Changer la voix de Siri ne résout pas les problèmes liés aux modèles linguistiques biaisés, qui n’ont pas besoin d’une voix féminine pour être utilisé. Il ne traite pas non plus les biais d’embauche dans l’entreprise, où les femmes ne représentent que 26% des postes de direction dans la recherche et le développement.

Si Apple va continuer à éliminer discrètement les préjugés sexistes de Siri, il reste encore beaucoup de travail à faire. Plutôt que de faire de petits changements progressifs, Apple devrait prendre de front le problème de la discrimination fondée sur le sexe et se distinguer en tant que leader.

Permettre à une grande partie de la population d’interagir avec une IA biaisée menace d’inverser les progrès récents des normes de genre. Rendre Siri et les autres assistants virtuels totalement exempts de biais devrait donc être une priorité immédiate pour Apple et les autres géants du logiciel.

Une nouvelle version de Siri pourrait baser le discours sur l’environnement et les entrées de l’utilisateur

Fourni par La Conversation

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l’article original.![]()

Citation: Les utilisateurs doivent désormais choisir entre les options de voix masculine et féminine pour Siri (2021, 15 juillet) récupéré le 15 juillet 2021 à partir de https://techxplore.com/news/2021-07-users-male-female-voice-options.html

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans l’autorisation écrite. Le contenu est fourni seulement pour information.

Sommaire